Özgün Adı: Why general artificial intelligence will not be realized

Öz

İnsan benzeri yapay zekâ (YZ) yaratma projesi II. Dünya Savaşı’ndan sonra, elektronik bilgisayarların sadece sayılarla uğraşan makineler olmadığı ve sembolleri de işleyebildikleri keşfedildiğinde başladı. Makine zekâsının insan zekâsına özdeş olduğunu varsaymadan da bu amacı gütmek mümkün ve bu zayıf YZ (weak AI) olarak biliniyor. Ancak pek çok YZ araştırmacısı, güçlü YZ olarak adlandırılan, prensipte insan zekâsı ile özdeş yapay zekâ geliştirme amacını izledi. Zayıf YZ, güçlü YZ’ye (strong AI) göre daha az iddialı ve bu nedenle daha az tartışmalı, ancak zayıf YZ ile ilgili de önemli tartışmalar mevcut. Bu metin yapay genel zekâ (YGZ; artificial general intelligence) ve yapay dar zekâ (YDZ; artificial narrow intelligence) arasındaki ayrıma odaklanıyor. YGZ, zayıf YZ olarak sınıflandırılabilecek olsa da güçlü YZ’ye yakın çünkü insan zekâsının ana özelliklerinden birisi onun genelliği. YGZ güçlü YZ’den daha az iddialı olmasına rağmen neredeyse başından beri eleştirilere konu olmuştur. Önde gelen eleştirmenlerden biri bedeni, çocukluğu ve kültürel uygulamaları olmayan bilgisayarların zekâyı hiçbir şekilde elde edemeyeceğini öne süren Hubert Dreyfus. Dreyfus’un ana argümanlarından biri insan bilgisinin kısmen zımni olduğu ve bu nedenle açıkça ifade edilemeyeceği ve bir bilgisayar programına dahil edilemeyeceğidir Ancak bugün yapay zekâ araştırmalarına olan yeni yaklaşımların bu argümanları geçerliliğini yitirmesine sebep olduğu söylenebilir. Derin öğrenme (deep learning) ve Büyük Veri (Big Data) en son yaklaşımlar arasında ve savunucuları YGZ’yi gerçekleştireceklerini öne sürüyorlar. Daha yakından baktığımızda görülebileceği üzere,belirli amaçlar için olan yapay zekânın (YDZ) gelişimi etkileyici olsa da yapay genel zekâ (YGZ) geliştirmeye çok da yaklaşamadık. Mevcut makale bunun prensipte mümkün olmadığını öne sürüyor ve Hubert Dreyfus’un bilgisayarların dünyada olmadığı argümanını yeniden diriltiyor.

Introduction

Makinelerin zekâ gerektiren işleri yapabileceği fikri en azından Descartes ve Leibniz’e kadar uzanıyor. Ancak 1950’leri erken yıllarında elektronik bilgisayarların sadece sayılarla yoğun hesaplamalar yapan cihazlar olmadığı ve sembolleri işlemek için kullanılabilecekleri fark edildiğinde, bu proje ileriye doğru büyük bir adım attı. Bu yapay zekâ (YZ) araştırmalarının doğuşuydu. Makine zekâsının insan zekâsına özdeş olduğunu varsaymadan da bu amacı gütmek mümkün. Örneğin alanın öncülerinden biri olan Marvin Minsky, YZ’yi “… eğer insanlar tarafından yapılsaydı zekâ gerektirecek olan işleri yapabilen makineler yapmanın bilimi” (akt. Bolter, 1986, s. 193) olarak tanımlıyor. Bu bazen zayıf YZ olarak adlandırılıyor. Ancak, pek çok YZ araştırmacısı, güçlü YZ olarak adlandırılan, prensipte insan zekâsı ile özdeş olan bir YZ geliştirme amacını izledi. Bu şunu gerektirir: “…bilgisayarların, kelimenin tam anlamıyla diğer bilişsel durumları anlayabildiği ve onlara sahip olabildiği göz önüne alındığında, uygun bir şekilde programlanmış bilgisayar, bir zihindir” (Searle, 1980, s. 417).

Bu metinde, tartışacağım meselelere daha uygun olan farklı bir terminoloji kullanacağım. İnsan benzeri YZ sıklıkla yapay genel zekâ (YGZ) olarak adlandırılır çünkü insan zekâsı geneldir. YGZ insan zekâsının temel bir özelliğine sahip olmasına rağmen hala zayıf YZ olarak değerlendirilebilir. Yine de belirli görevlerle veya alanlarla kısıtlanmış olan geleneksel zayıf YZ’den farklıdır. Bu nedenle geleneksel zayıf YZ bazen yapay dar zekâ (YDZ) olarak adlandırılır (Shane, 2019, s. 41). Bazen güçlü YZ’ye atıfta bulunacak olsam da bu makaledeki temel ayrım YGZ ve YDZ arasında. Bu ikisini ayrı tutmak önemli. YDZ’deki ilerlemeler, YGZ’de ilerleme değildir.

1976 yılında Joseph Weizenbaum Bilgisayar Gücü ve İnsan Aklı (Computer Power and Human Reason; Weizenbaum, 1976) isimli kitabı yayınladı. Kendisi o zaman MIT’de bilişim profesörü ve Eliza isimli ünlü programın yaratıcısıydı. Başlığın belirttiği gibi, Weizenbaum bilgisayarın gücü ve insan aklı arasında bir ayrım yaptı. Bugünün terminolojisi ile bilgisayarın gücü algoritmaları muazzam hızlarda kullanma becerisiydi ki bu da YDZ’dir. Bilgisayarın gücü asla insan aklına dönüşecek şekilde gelişmeyecek çünkü ikisi temel olarak farklılar. “İnsan aklı” Aristoteles’in sağduyu ve bilgelik kavramlarını içerirdi. Sağduyu somut durumlarda doğru kararı verme becerisiyken, bilgelik bütünü görme becerisidir. Bu beceriler algoritmik değildir ve bu nedenle bilgisayarın gücü insan aklının yerine geçemez ve geçmemelidir. Birkaç yıl sonra matematikçi Roger Penrose insanın düşünmesinin temelde algoritmik olmadığını gösterdiği iki büyük kitap yazdı (Penrose, 1989, 1994).

Fakat benim argümanlarım, Weizenbaum’un ve Penrose’un argümanlarından kısmen farklı olacak. Orijinalinde felsefeci Hubert Dreyfus tarafından sunulmuş olan argümanlar çizgisini takip edeceğim. Dreyfus YZ araştırmalarına az çok kazara girdi. Önceden iki felsefeci, Martin Heidegger ve Ludwig Wittgenstein ile ilgili çalışmalar yapmıştı. Bu felsefeciler, bilim dünyasının aksine insan bedeninin ve pratik aktivitenin önemine birincil olarak vurgu yaparak ana akım batı felsefesinde bir kırılmayı temsil ediyorlardı. Örneğin Heidegger bir çekiç veya bir sandalye kavramına sahip olabilmemizin tek sebebinin içinde büyüdüğümüz bir kültüre ait olmamız ve bu objeleri kullanabilmemiz olduğunu öne sürüyordu. Bu nedenle Dreyfus bedeni, çocukluğu ve kültürel uygulamaları olmayan bilgisayarların zekâyı hiç elde edemeyeceğini düşündü (Dreyfus ve Dreyfus, 1986, s.5).

1950’lerde ve 1960’larda, YZ araştırmaları için önemli yerlerden biri Rand şirketiydi (Rand Corporation). Tuhaf bir şekilde,1964 yılında Dreyfus’u danışman olarak işe aldılar. Ertesi yıl Dreyfus, “Simya ve Yapay Zekâ” (Alchemy and Artificial Intelligence) başlıklı bir eleştiri raporu verdi. Ancak Rand içerisindeki YZ projesi liderleri raporun saçmalık olduğunu ve yayınlanmaması gerektiğini öne sürdüler. Rapor sonunda yayınlandığında, Rand şirketinin tarihindeki en fazla talep edilen rapor haline geldi. Dreyfus daha sonrasında raporu genişleterek Bilgisayarlar Neyi Yapamaz (What Computers Can’t Do; Dreyfus, 1972) isimli bir kitap haline getirdi. Kitapta insan bilgisinin önemli bir parçasının zımni olduğunu ve bu nedenle bilgisayar programı içerisinde açıkça ifade edilemez ve uygulanamaz olduğunu öne sürdü.

Dreyfus bazı YZ araştırmacıları tarafından şiddetle saldırıya uğramış olsa da şüphesiz ciddi bir soruna işaret etmişti. Fakat 1980’lerde YZ araştırmalarında başka bir paradigma baskın hale geldi. Bu paradigmanın temeli nöral ağlar (neural networks) fikriydi. Bu fikir, sembollerin kullanılmasını bir model olarak almak yerine, sinir sistemimizin ve beynimizin süreçlerini bir model olarak aldı. Bir nöral ağ açık talimatlar almaksızın öğrenebilir. Böylece Dreyfus’un bilgisayarların ne yapamayacağıyla ilgili argümanları geçerliliğini yitirmiş gibi görünmüştü.

Alandaki en son gelişme Büyük Veri. Büyük Veri, korelasyonlar bulmak ve olasılıklar çıkarsamak için matematiksel yöntemlerin devasa miktarlarda veriye uygulanmasıdır (Najafabadi et al., 2015). Büyük Veri ilginç bir zorluk teşkil ediyor: Daha önce YGZ’nin güçlü YZ’nin parçası olmadığından bahsetmiştim. Ancak, her ne kadar Büyük Veri güçlü YZ geliştirme iddiasını temsil etmiyor olsa da savunucuları bunun gerekli olmadığını öne sürüyorlar. Bizim insan benzeri zekâya sahip bilgisayarlar geliştirmemize gerek yok. Aksine, kendi düşünme biçimimizi bir bilgisayarınkine benzeyecek şekilde değiştirebiliriz. Bu Viktor Mayer-Schönberger ve Kenneth Cukier’in Büyük Veri: Yaşama, Çalışma ve Düşünme Şeklimizi Dönüştürecek Bir Devrim (Big Data: A Revolution That Will Transform How We Live, Work, and Think; Mayer-Schönberger ve Cukier, 2014) kitabının örtük bir mesajı. Kitap, Büyük Veri’nin neyi başarabileceği ve bunun kişisel hayatlarımızdaki ve bir bütün olarak toplumdaki olumlu etkisi hakkında iyimser.

Bazıları hipotezleri, nedensel modelleri ve testleri kullanan geleneksel bilimsel yöntemin geçerliliğini yitirmiş olduğunu bile öne sürdüler. Nedensellik özellikle bilimde insan düşünmesinin önemli bir parçası fakat bu görüşe göre nedenselliğe ihtiyacımız yok, korelasyonlar yeterli. Örneğin suça ilişkin verileri kullanarak, suçların nerede oluşacağını çıkarsayabilir ve bunu polis kaynaklarını tahsis etmek için kullanabiliriz. Hatta suçları, işlenmeden önce öngörebilir ve böylece engelleyebiliriz.

Eğer YZ araştırmaları literatürüne biraz bakarsak, sanki araştırmaların birkaç on yıl içerisinde başarabileceklerinin bir limiti yokmuş gibi görünüyor. Bunun bir örneği yukarıda bahsettiğim Mayer-Schönberger ve Cukier’in kitabı. İşte kitaptan bir alıntı:

“Gelecekte -ve bizim düşünebileceğimizden daha yakın bir zamanda-, dünyamız pek çok açıdan bugün insan yargısının yegane amacı olan bilgisayar sistemleri tarafından artırılmış veya değiştirilmiş olacak. (Mayer-Schönberger ve Cukier, 2014, s. 12)”

Bu görüşü destekleyen bir örnek 2012 yılında Obama Yönetimi (Obama Administration) tarafından “ulusların en öncelikli zorluklarının bazılarını çözmeye yardımcı olmak” için başlatılan “Büyük Veri Araştırma ve Geliştirme Girişimi” (Big Data Research and Development Initiative; akt. Chen ve Lin, 2014, s. 521).

Ancak vaat edilene kıyasla nelerin gerçekten başarıldığına baktığımızda gördüğümüz tutarsızlık çarpıcı. Daha sonra bazı örnekler vereceğim. Bu tutarsızlığın bir açıklaması, itici kuvvetin kâr olması ve bu yüzden pek çok vaadin pazarlama olarak değerlendirilmesi gerektiği ihtimali olabilir. Fakat ticari çıkarların rolü olduğuna kuşku olmasa da ben bu açıklamanın yetersiz olduğunu düşünüyorum. İki faktör ekleyeceğim: İlki, Silikon Vadisi’ndeki birkaç muhaliften biri olan Jerone Lanier, bilimsel ölümsüzlüğe, süper zekâya sahip bilgisayarların gelişimine vs. olan inancın yeni bir dinin “bir mühendislik kültürü ile ifade edilen” anlatımları olduğunu öne sürüyor (Lanier, 2013, s. 186). İkincisi, bilgisayarların bir insan aktivitesini kopyalayabileceği öne sürüldüğü zaman, iddianın sıklıkla bu aktivitenin oldukça basitleştirilmiş ve çarpıtılmış bir açıklamasının ön kabulüne dayandığı ortaya çıkıyor. Basitçe ifade etmek gerekirse: Teknolojinin abartılması, insanların hafife alınmasıyla yakından bağlantılı.

Dreyfus’un YGZ’nin gerçekleştirilemeyeceğiyle ilişkili olan ana argümanıyla başlayacağım. Daha sonra, Dreyfus’un kitabı yayınlandıktan sonra YZ araştırmalarında gerçekleşen gelişmeleri kısaca anlatacağım. Bazı inanılmaz atılımlar, YGZ’nin sonraki birkaç on yılda gerçekleştirilebileceği iddiasını desteklemek için kullanıldı fakat YGZ’nin gerçekleştirilmesinde çok az şey başarıldığını göstereceğim. Sonrasında bunun sadece bir zaman, yani yakın zamanda gerçekleştirilememiş olanın daha sonra gerçekleştirileceği meselesi olmadığını savunacağım. Aksine, bu amacın prensipte gerçekleştirilemez olduğunu ve bu projenin bir çıkmaz sokak olduğunu iddia edeceğim. Yazının ikinci kısmında, nedensel bilginin insan benzeri bir zekânın önemli bir parçası olduğunu ve bilgisayarların nedenselliği kullanamayacağını çünkü dünyaya müdahale edemeyeceklerini tartışmakla yetineceğim. Daha genel olarak, YGZ gerçekleştirilemez çünkü bilgisayarlar dünyada değiller. Bilgisayarlar büyümediği, bir kültüre mensup olmadıkları ve dünyada eyleme geçmedikleri sürece asla insan benzeri bir zekâ elde edemeyecekler.

Son olarak, YGZ’nin gerçekleştirilebileceği inancının zararlı olduğunu önse süreceğim. Eğer teknolojinin gücü abartılırsa ve insan becerileri hafife alınırsa, pek çok durumda sonuç bizim iyi çalışan bir şeyi daha aşağı bir şeyle değiştirmemiz olur.

Zımni bilgi

Dreyfus YZ’yi Platon’a kadar giden bir felsefi geleneğin içine yerleştirdi. Platon’un bilgi teorisi matematik, özellikle de geometri ideali üzerine inşa edilmiştir. Geometri maddi cisimlerle değil ideal cisimlerle ilgilidir. Gerçek bilgiyi, epistemeyi, sadece dikkatimizi maddi dünyadan “yukarılara”, ideal nesnelerin dünyasına çevirerek elde edebiliriz. Hatta Platon geometricileri kendi işlerini anlamamakla suçlamış; geometricilerin “bir şey yaptıklarını ve muhakemelerinin pratik bir tarafı olduğunu” düşündüklerini ve “aslında konunun yalnızca bilgi uğruna takip edilmediğini” söyleyerek eleştirmiştir (Plato, 1955, s. 517). Beceriler sadece görüştür, doxa[1]dır ve Platon’nun bilgi hiyerarşisinin en altına indirilmiştir.

Bu görüşe göre bir şeyin bilgi olarak değerlendirilmesinin asgari gerekliliği, açık bir şekilde formüle edilebilmesidir. Batı felsefesi genellikle Platon’u takip ederek sadece önermesel bilgiyi gerçek bilgi olarak kabul etti. Buna bir istisna Dreyfus tarafından “anti felsefeciler” olarak adlandırılan Merleau-Ponty, Heidegger ve Wittgenstein. Dreyfus ayrıca bilim insanı ve felsefeci Michael Polanyi’yi de kastediyor. Polanyi, Kişisel Bilgi (Personal Knowledge) kitabında zımni bilgi (tacit knowledge)[2] ifadesini tanıtmıştı. Bizim gündelik yaşamda başvurduğumuz bilgilerin çoğu zımnidir. Aslında bir işi yaparken hangi kurallara başvurduğumuzu bilmiyoruz. Polanyi, yüzmeyi ve bisiklet sürmeyi birer örnek olarak kullanmıştır. Pek az sayıda yüzücü onları su üstünde tutan şeyin solunumlarını nasıl düzenledikleri olduğunu bilir: Nefes verdiklerinde ciğerlerini boşaltmazlar ve nefes aldıklarında ciğerlerini normalden daha fazla şişirirler.

Benzer bir şey bisiklet sürmede de geçerli. Bisikletçi, dengesini gidonu döndürerek sürdürür. Sola düşmekten kaçınmak için gidonu sola çevirir ve sağa düşmekten kaçınmak için gidonu sağa çevirir. Böylece dengesini bir dizi ufak kavislenme ile hareket ederek sürdürür. Polanyi’ye göre, basit bir analiz gösteriyor ki belirli bir dengesizlik açısı için, her kavisin eğriliği bisikletin hızının karesiyle ters orantılı. Fakat bisikletçi bunu bilmez ve bilmesi de onun daha iyi bisikletçi olmasına yardım da etmezdi (Polanyi, 1958, s. 50). Daha sonra Polanyi bu içgörüyü “… anlatabileceğimizden daha fazlasını bilebiliriz” olarak formüle etmiştir (Polanyi, 2009, s.4).

Ancak, Polanyi’nin katkısındaki önemli bir nokta, becerilerin genel olarak sözlü ifade edilebilecek (articulate) bilgi ve özel olarak bilimsel bilgi için bir ön koşul olduğunu öne sürmesi. Örneğin, fiziksel deneyler gerçekleştirmek için yüksek derecede beceri gerekir. Bu beceriler sadece ders kitaplarıyla öğrenilemez. İşi bilen birinden gelen talimatlar aracılığıyla elde edilir.

Benzer şekilde kardeşi Stuart ile birlikte Hubert Dreyfus becerilerin edinilmesiyle ilgili bir model geliştirdi. En düşük seviyede, işi yerine getiren kimse açık kuralları takip eder. En yüksek seviye, uzman performansı, Polanyi’nin bilimsel uygulama açıklamasına benzer. Uzmanlığın önemli bir kısmı zımnidir. Bir bilgisayarın uzman performansını (örneğin tıbbi teşhis) simüle etmesini sağlayan sistemlerin, yani uzman sistemlerin gelişiminin karşılaştığı problem, uzman bilgisinin önemli bir kısmının zımni olmasıdır. Eğer uzmanlar performansları sırasında başvurdukları bilgiyi açıkça ifade etmeyi denerlerse, normal olarak daha düşük bir seviyeye gerilerler. Bu yüzden Hubert ve Stuart Dreyfus’a göre uzman sistemler, uzman bir kimsenin becerilerini yakalayamayacaktır (Dreyfus ve Dreyfus, 1986, s. 36). Bu olguyu gündelik hayattan biliyoruz. Pek çoğumuz yürümede uzmanız. Ancak, nasıl yürüdüğümüzü açıkça ifade etmeye çalıştığımızda, yürümeyle ilgili becerileri pek de yakalayamayan bir tanımlama yapıyoruz.

YZ araştırmalarındaki üç “dönüm noktası”

Yine de, Hubert Dreyfus’un Bilgisayarlar Neyi Yapamaz (What Computers Can’t Do isimli yayınından sonra YZ muazzam bir ilerleme gösterdi. Büyük dikkat çekmiş ve YGZ’nin “eli kulağında” olduğu izlenimine katkı sağlamış üç “dönüm noktası”ndan bahsedeceğim.

İlk “dönüm noktası”, 1997 yılında dünya satranç şampiyonu Garri Kasparov’u yendiği için sıklıkla bir kırılma noktası olarak değerlendirilen IBM’in satranç oynayan bilgisayarı Deep Blue. Fakat Deep Blue bir YDZ örneğiydi; belirli bir amaç için yapılmıştı. Her ne kadar insanlar tarafından yapıldığında zekâ gerektiren bir aktivitede son derece başarılı olsa da kimse Deep Blue’nun genel zekâ edindiğini iddia etmez.

İkincisi IBM’in bilgisayarı Watson. Bu, Jeopardy! isimli bilgi yarışmasına katılma amacıyla geliştirildi. Bu yarışmada katılımcılara cevapların veriliyor ve katılımcıların doğru soruyu bulması gerekiyor. Örneğin şöyle bir cevap sunulabilir: “Bu `Ülkemizin Babası’ gerçekten kiraz ağacı kesmedi”. Katılımcıların bulması gereken doğru cevap: George Washington kimdir?”[3]

Jeopardy!, satrançtan çok daha büyük bir bilgi ve beceri repertuarı gerektiriyor. Görevler bilim, tarih, kültüre, coğrafya ve spor gibi çeşitli alanları kapsıyor ve analojiler ve cinaslar barındırabiliyor. İlk cevap veren olmak için yarışan üç katılımcı var. Eğer biri yanlış cevaplarsa, o yarışmacı çekiliyor ve başka bir yarışmacı cevaplama fırsatına sahip oluyor. Bu nedenle yarışma hem bilgi hem hız gerektiriyor ama aynı zamanda kendini sınırlama becerisi de gerektiriyor. Program, 1964’te başladığından beri Birleşik Devletler’de muazzam bir popülarite kazandı ve ortalama yedi milyon insan tarafından izleniyor (Brynjolfson ve McAfee, 2014, s.24).

Watson doğal dil kullanarak iletişim sağlıyor. Jeopardy! yarışmasına katıldığında, internete bağlı değildi ama 200 milyon sayfa bilgiye erişimi vardı (Susskind ve Susskind, 2015, s. 165; Ford, 2015, s. 98ff). Watson, 2011 yılında Jeopardy! yarışmasının en iyi katılımcılarından ikisini, Ken Jennings’i ve Brad Rutter’ı yendi. Jennings, 2004 yılında arka arkaya 74 kere kazanarak toplamda 3 milyon doların üzerinde kazanmıştı. Rutter, 2005’te Jennings karşısında kazanmış ve o da 3 milyon doların üzerinde kazanmıştı. İki gün süren yarışmada, Watson insan rakiplerinin her birinin kazandığından üç katından daha fazla kazandı.

Watson, Jeopardy! yarışmasına katılmak için yapılmış olsa da IBM’in başka planları da vardı. Watson Jeopardy! yarışmasını kazandıktan kısa süre sonra şirket, bilgisayarın gücünü tıbba uygulayacaklarını duyurdu: Bu bir YZ tıbbi süper doktoru olacak ve tıpta devrim yapacaktı. Temel fikir şuydu: eğer Watson bütün tıbbi literatüre (hastaların sağlık kayıtları, ders kitapları, akademik makaleler, ilaçların listeleri vb.) erişime sahip olursa, herhangi bir insan doktordan daha iyi bir tanı ve tedavi önerebilmesi gerekirdi. Takip eden yıllarda IBM birkaç projeye girişti ancak başarı oldukça sınırlıydı. Bazıları sadece kapatıldı, bazıları ise olağanüstü derecede başarısız oldu. Bir YZ doktor oluşturmak başta varsayılandan çok daha zordu. IBM’e ait Watson Health, süper doktorlar yerine rutin görevleri yerine getirebilen bir YZ asistanına dönüştü (Strickland, 2019).

Üçüncü “dönüm noktası” Alphabet’den AlphaGo. Go, Çin’de 2000 yıldan daha eski bir dönemde icat edilmiş bir masa oyunu. Oyunun karmaşıklığı satrançtan bile daha fazla olarak görülüyor ve oyun milyonlarca insan tarafından oynanıyor, özellikle de Doğu Asya’da. AlphaGo, dünya şampiyonu Le Sedol ile olan Güney Kore, Seul’daki çokça reklamı yapılmış beş maçta galip geldi. Olay ödüllü AlphaGo isimli filmde resmedildi (2017, Greg Kohs tarafından yönetildi).

AlphaGo, YZ araştırmalarında bir dönüm noktası kabul ediliyor çünkü bu derin pekiştirmeli öğrenme (deep reinforcement learning) adındaki bir stratejinin uygulamasının bir örneği. Bu durum, şirketin “DeepMind” (DerinZihin) isminde yansıtılıyor. (Google’ın yeniden yapılanmasından sonra Google ve DeepMind, Alphabet’in yan kuruluşu oldu.) Bu yapay nöral ağlar paradigması temelindeki YZ araştırmalarına yaklaşımın bir örneği. Bir yapay nöral ağ, nöral ağlar üzerine modellenir. Beynimiz yaklaşık yüz milyar nöron barındırır. Her bir nöron, yaklaşık 1000 nörona sinapslar aracılığıyla bağlıdır. Bu, beyinde yaklaşık yüz trilyon bağlantı olduğu anlamına geliyor. Bir yapay nöral ağ, doğal nöronlardan çok daha basit olan yapay nöronlardan oluşuyor. Ancak, çok sayıda nöron bir ağ içerisinde bağlandığı zaman, yeterince büyük bir ağın teoride herhangi bir hesaplamayı gerçekleştirebileceği kanıtlandı. Pratikte neyin mümkün olduğu tabii ki başka bir soru (Minsky, 1972, s. 55; Tegmark, 2017, s. 74).

Nöral ağlar özellikle desen tanımada iyiler. Örneğin, bir nöral ağa bir resimdeki kediyi saptamasını öğretmek için bizim kediyi saptamak için kullandığımız ölçütleri programlamak zorunda değiliz. Bir dereceye kadar farkları açıklayabiliriz ancak çok az sayıda kişi, muhtemelen hiç kimse, kullanılan bütün ölçütlerin tam bir listesini veremeyecektir. Bunun sebebi zımni bilginin çoğunluğunun örnekler ve karşı örnekler ile öğrenilmesidir. Aynısı nöral ağlar için de geçerli.

Bir derin öğrenme nöral ağı farklı yapay nöron katmanlarından oluşur. Örneğin bir ağ dört farklı katmana sahip olabilir. Bir resmin analizinde, ilk katman pikselleri ışık ve karanlık olarak saptayabilir. İkinci katman kenarları ve basit şekilleri saptayabilir. Üçüncü katman daha karmaşık şekilleri ve nesneleri saptayabilir ve dördüncü katman hangi şekillerin bir nesneyi saptamak için kullanılabileceğini öğrenebilir (Jones, 2014, s. 148).

Bunun avantajı, bir yüzü saptamakta kullanılan ölçütleri açık bir şekilde formüle etmenin gerekli olmaması. Bu satranç programı Deep Blue ve AlphaGo arasındaki hayati fark. İnsan bir satranç oyuncusu tahtadaki belirli bir pozisyonu değerlendirmek için hesaplama ve sezgi karışımı kullansa da Deep Blue belirli bir durumda, çok sayıda olası pozisyonu değerlendirmek ve en iyi olasılığa karar vermek için programlandı. Go ise farklı. Pek çok durumda usta oyuncular sadece sezgilerine güveniyor ve tahtadaki pozisyonu sadece “iyi bir şekle” sahip olarak tanımlayabiliyorlar (Nielsen, 2016). Daha önce Hubert Dreyfus’un YGZ’ye karşı olan ana argümanlarından birinin insan uzmanlığının kısmen zımni olduğu ve açıkça ifade edilemeyeceği olduğundan bahsetmiştim. AlphaGo bilgisayarların zımni bilgiyi kullanabileceğini gösterdi ve bu yüzden Dreyfus’un argümanı geçerliliğini yitirmiş gibi görünüyor. Ancak daha sonra “zımni bilgi”nin Dreyfus’un zihnindeki insan dünyasından temelde farklı olan idealize edilmiş bir “bilim dünyası”yla sınırlı olduğunu göstereceğim.

Yine de, açık kuralları formüle etmek zorunda olmama avantajı bir bedel ile geliyor. Geleneksel bir bilgisayar programında bütün parametreler açıktır. Bu tam şeffaflığı garanti eder. Bir nöral ağda bu şeffaflık kayıp. Kişi genelde hangi parametrelerin kullanıldığını bilmez. Birkaç yıl önce, Washington Üniversitesinden bir ekip haskiler ve kurtlar arasında ayrım yapmak için eğitilmiş bir sistem geliştirdi. Bu dikkate değer ölçüde beceri gerektiren bir iş çünkü aralarında çok fazla bir fark yok. Buna rağmen, sistem hayrete düşüren %90’lık bir doğruluğa sahipti. Ancak, ekip keşfetti ki sistemin kurtları tanımasının sebebi pek çok kurt fotoğrafında kar olmasıydı. Ekip bir kar dedektörü icat etmişti! (Dingli, 2018)

AlphaGo, DeepMind araştırmacıları tarafından geliştirildi ve bu büyük bir başarı olarak değerlendirildi. DeepMind’ın yaklaşımı, Atari oyunları Breakout ve Space Invaders ve bilgisayar oyunu Starcraft için de başarılı bir şekilde uygulandı. Ancak, ortaya çıktı ki sistem esneklikten yoksun ve çevredeki değişikliklere uyum sağlayamıyor. Hatta küçük çevredeki küçük bir değişime karşı bile savunmasız olduğu görüldü. Gerçek dünya problemleri değişen bir dünyada yer aldığından dolayı derin pekiştirmeli öğrenmenin şimdiye kadar ancak birkaç ticari uygulaması bulundu. Araştırma ve geliştirme maliyetli ama DeepMind’ın 2016’daki 154 milyon dolarlık, 2017’deki 341 milyon dolarlık ve 2018’deki 572 milyon dolarlık kayıpları pek de başarı işareti değil (Marcus, 2019).

En yeni abartılı pazarlama: Büyük Veri

Nöral ağlarla ilgili zorluk, çok büyük miktarda veriyle başa çıkabiliyor olmaları gerekmesi. Örneğin AlphaGo başlangıçta, yetkin Go oyuncuları tarafından oynanmış 150.000 oyun üzerinde eğitildi. Daha sonra kendisinin önceki versiyonlarına karşı tekrar tekrar oynayarak geliştirildi.

Bilgisayarların çok büyük miktarlardaki veriyi işlemedeki ve depolamadaki artan becerisi “veri patlaması”, hatta “veri tufanı”, olarak adlandırılan şeye yol açtı. Daha 2012’de Google’ın her gün yaklaşık 24 petabit (24 1015) veri işlediği tahmin ediliyordu. Bu ABD’nin Kongre Kütüphanesindeki basılı materyal sayısının bin katı (Mayer-Schönberger ve Cukier, 2014, s. 8). Ayrıca dünyada her gün 2.5 exabit (2.5 1018) veri üretildiği tahmin ediliyor. Bunun şimdiye kadar insanlar tarafından konuşulmuş bütün kelimelerin yaklaşık olarak yarısı olduğu tahmin ediliyor. Bu büyüklükte bir veri insan hayal gücünün ötesinde ve Büyük Veri yaklaşımının arka planı.

Büyük Veri yaklaşımı büyük miktarda verinin -tipik olarak terabitler ve petabitler- analizi için ilave bir yöntem olarak değerlendirilmesi mümkün olsa da bazen yeni bir epistemolojik yaklaşım olarak sunuluyor. Viktor Mayer-Schönberger ve Kenneth Cukier, kitapları Büyük Veri’ye 2009’da keşfedilmiş bir grip örneğiyle başlıyorlar. Kuş gribi ve domuz gribine sebep olan virüslerden öğeleri birleştiren bu virüse H1N1 adı verildi. Grip hızlıca yayıldı ve bir hafta içinde, dünya çevresindeki halk sağlığı kurumları bir salgın hakkında endişelendiler. Hatta bazıları, milyonları öldüren 1918 İspanyol gribi ile aynı büyüklükte bir salgın hakkında endişelendiler. Virüse karşı hiç aşı yoktu ve sağlık yetkililerinin yapabileceği tek şey virüsü yavaşlatmayı denemekti. Fakat bunu yapabilmek için, virüsün halihazırda yayıldığı yerleri bilmeleri gerekiyordu. Doktorlardan yeni vakaları bildirmeleri istenmiş olsa da bu bilgilerin yetkililere ulaşması 1–2 hafta alacaktı, bunun ana sebebi hastaların hastalığın semptomlarının ortaya çıkışından hemen sonra doktora danışmamaları.

Ancak Google’daki araştırmacılar bu salgından hemen önce gribin yayılmasını çok daha iyi bir şekilde öngörecek yeni bir yöntem icat ettiler. Google her gün üç milyonun üzerinde soru araması alıyor ve hepsini kaydediyor. Grip semptomları olan insanlar, grip hakkındaki bilgiler için internette arama yapma eğilimindeydiler. Bu yüzden araştırmacılar, griple yüksek korelasyon gösteren arama öğelerine bakarak, sağlık otoritelerine kıyasla çok daha hızlı bir şekilde gribin yayılışını haritalayabildiler (Mayer-Schönberger ve Cukier, 2014, s. 2).

Mayer-Schönberger ve Cukier bunu bir başarı öyküsü olarak değerlendiriyor. Fakat bu bazen “ilk başarının yanılgısı” olarak adlandırılan şeyin bir örneği olabilir. 2013 yılında model grip benzeri hastalıklar için olan doktor ziyaretlerini, güvenilir bir bilgi kaynağı olarak görülen Hastalık Kontrol ve Koruma Merkezlerinin iki katı olarak raporladı. Modelin ilk versiyonu muhtemelen griple korele olan ama nedensel olarak alakasız olan dönemsel veriler içeriyordu. Bu nedenle model kısmen grip kısmen kış dedektörüydü. Model güncellenmiş olsa da performansı başlangıçtaki vaatlerin çok altında (Lazer et al., 2014; Shane, 2019, s. 171).

Korelasyonlar ve nedenler

Önceki örnekler sadece korelasyonlarla ilgiliydi. Ancak bilimde ve gündelik yaşamda nedensel ilişkilere sahip olmak isteriz. Örneğin günümüzün en büyük sorularından biri nedensel bilgi ile alakalı: Gözlemlediğimiz küresel ısınma insan aktivitesinden (atmosfere sera gazı salınımı) mi kaynaklanıyor yoksa sadece doğal bir varyasyon mu?

Nedensel ilişkinin doğası yüzyıllarca tartışıldı, özellikle David Hume’un neden ve sonuç arasındaki zorunlu ilişki ile ilgili eski düşünceleri eleştirmesinden sonra. Hume’a göre düzenliliklerin gözlemiyle tatmin olmamız gerekiyor. Tersi bir şekilde, onun çağdaşı olan Immanuel Kant, nedensel ilişkilerin bilginin elde edilmesi için bir ön koşul olduğunu öne sürüyor, her sonucun bir nedeni olması gereklidir.

Ancak, nedensel ilişkiler üzerine şimdiye kadar süregelmiş bir felsefi tartışmaya girmek yerine, neleri nedensel ilişki olarak tanımladığımıza bakmak kazançlı olacaktır. Felsefeci John Stuart Mill, nedensel ilişkileri tanımlamamızı sağlayacak bazı kurallar (o bunları “kanonlar” olarak adlandırıyor) formüle etti. Onun, aynı zamanda “farklar metodu” olarak da isimlendirilen ikinci kuralı şu şekilde:

“Eğer incelenen olgunun oluştuğu bir olayın ve oluşmadığı bir olayın sadece ilkinde oluşan durum dışında bütün durumları ortaksa, iki olayın farklılaştığı tek durum olgunun sonucu veya nedeni veya nedeninin ayrılmaz bir parçasıdır” (Mill, 1882, s. 483).

Bu atıftan gördüğümüz üzere bir nedensel ilişkinin ayırt edici işareti neden ve sonuç arasındaki %100 korelasyondur. Ama korelasyonların çoğu nedensel değildir. Örneğin, benzin fiyatları ve benim yaşım arasında yüksek bir pozitif korelasyon var ama bariz bir şekilde ikisi arasında nedensel bir ilişki yok. Bu yüzden korelasyon bir nedensel ilişkinin göstergesi olabilir ama olmak zorunda değil.

Yukarıdaki atıfta bu nedenle Mill, iki olayın bütün koşullarınıneşit olması gerektiğini ifade ediyor. Fakat hala tek erişebileceğimiz şey ikisi arasındaki farkın neden veya sonuç olduğudur, çünkü korelasyon simetrik bir matematiksel ilişkidir: Eğer A, B ile koraleyse o zaman B, A ile koraledir. Bunun aksine eğer C, E’nin nedeniyse E, C’nin nedeni değildir. Bu yüzden korelasyon neden ve sonuç arasında ayrım yapamaz. Bu ayrımı yapmak için daha fazlasına ihtiyacımız var: Neden, sonucu üretir ya da en azından beraberinde getirir. Bu nedenle varsayılan nedeni kaldırabilir ve sonucun oluşup oluşmadığına bakabiliriz.

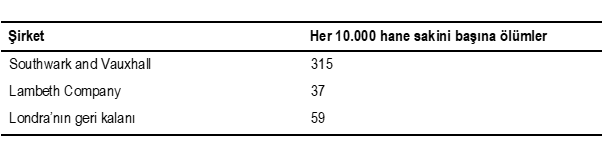

Bu prosedürün ünlü bir örneğine tıp (spesifik olarak epidemiyoloji) tarihinden sahibiz. Londra’da, 1850 yılında bir kolera salgını vardı. John Snow bir pratisyen hekimdi. Snow koleranın sıklığı ve insanların suyu hangi şirketten aldıkları arasında bir bağlantı olduğunu fark etti. Thames’deki kirli bir alanda su alımı yapan Southwark and Vauxhall şirketi yüksek kolera vakaları oranına sahipti. Diğer bir şirket olan Lambeth Company önemli ölçüde daha düşük sayılara sahipti. Bu hastalık yapıcı bakteri teorisinden önce olsa da Snow, hastalığın nedeninin suda bulunduğunu varsaydı. Snow’un sayıları şöyleydi:

Snow hastalık taşıyan su barındırdığına inandığı su pompasını mühürledikten sonra kolera salgını bitti (Saga, 1996, s. 76).

Eğer sonuç her zaman nedeni takip ediyorsa, diğer her şey eşitse, elimizde deterministik nedensellik vardır. Ancak pek çok insan sigara içiyor ve kansere yakalanmıyorlar. Sorun şu ki pratikte bazı belirsizlikler söz konusu. Bu yüzden neden ve sonuç arasında <%100 korelasyona sahip olduğumuz durum için bir nedensel ilişki tanımına ihtiyacımız var. Bu tanıma göre olasılıksal bir neden her zaman etki tarafından takip edilmez ama etkinin sıklığı, nedenin var olmadığı duruma göre daha yüksektir. Bu, P(S|N) > P(S|N-değil) olarak yazılabilir. P(S|N) bir şartlı olasılık ve “N verildiğinde S’nin olasılığı” olarak okunabilir.

Ancak bu basit görünse de değil. Bir örnek bunu gösterecektir. II. Dünya Savaşı’ndan sonra, sigara içmenin akciğer kanserine neden olabileceğiyle ilgili pek çok gösterge vardı. Bu soruya basit bir şekilde cevap verilebilirmiş gibi görünüyor: Kişi tüm alakalı yönleriyle benzer olan iki grup insan seçer. Bir grup sigara içmeye başlar ve diğer grup başlamaz. Bu basit bir randomize, klinik çalışma. Sonra kişi, 10 yıl, 20 yıl, 30 yıl sonra ve devamında iki gruptaki akciğer kanseri sıklığında bir fark var mı diye kontrol eder.

Tabii ki eğer sigara içmek iddia edildiği kadar tehlikeliyse bunu keşfetmek için onlarca yıl beklenmez. Bu yüzden kişi eldeki popülasyonu ve korelasyonları kullanmak zorunda: Kişi akciğer kanserine sahip insanlardan ve kansere yakalanmamış popülasyondan birer örneklem alır ve farklı arka plan etkenlerine bakar: Akciğer kanserine yakalanmış insanlar arasında sigara içenlerin sıklığı yakalanmamış insanlardakine göre daha mı fazla? Buradaki ana ölçüt “ceteris paribus”, diğer her şey eşit.

Mesele bazen nedensel ilişkiler bulmak için korelasyonlar kullanmak zorunda olduğumuzu kabul etmek. Nedenlere hiçbir şekilde ihtiyacımız olmadığını öne sürmek oldukça başka bir konu. Yine de bazıları nedensel ilişki olmadan da idare edebileceğimizi öne sürüyor. 2008 yılında Wired Magazine baş editörü Chris Anderson Teorinin Sonu: Veri Tufanı Bilimsel Yöntemi Gereksiz Kılıyor, (The End of Theory: The Data Deluge Makes the Scientific Method Obsolete) başlıklı bir makale yazdı. Makalede korelasyonların yeterli olduğunu, çok büyük oranda veri kullanabildiğimizi ve bilimin bulamayacağı desenler bulmak için istatistiksel algoritmalara izin verebileceğimizi iddia etti. Hatta daha da ileri giderek hipotezler, nedensel modeller ve testler kullanan geleneksel bilimsel yöntemin geçerliliğini yitirmiş olduğunu öne sürdü (Anderson, 2008).

Mayer-Schönberger ve Cukier’e göre, Anderson’ın makalesi ateşli bir tartışmaya sebep oldu,“… Anderson hızlı bir şekilde daha sert iddialarından dönmüş olsa da” (Mayer-Schönberger ve Cukier, 2014, s. 71). Fakat Anderson orijinal iddialarını değiştirse bile Mayer-Schönberger ve Cukier pek çok durumda nedensel ilişkileri bilmeden de devam edebileceğimiz konusuna katılıyorlar: “Büyük Veri ne hakkında, neden hakkında değil. Her zaman bir olgunun sebebini bilmemiz gerekmiyor; bunun yerine verinin kendisi adına konuşmasına izin verebiliriz” (Mayer-Schönberger ve Cukier, 2014, s. 14). Daha sonra bunu şu şekilde açıkça ifade ettiler: “Nedensellik ıskartaya çıkartılmayacak ama anlamın birincil çeşmesi olarak durduğu kaidesinden düşürülüyor. Büyük Veri sıklıkla nedensel araştırmaların yerine geçen nedensel olmayan analizleri hızlandıracak” (Mayer-Schönberger ve Cukier, 2014, s. 68). Pearl ve Mackenzie bunu şu şekilde ifade ediyor: “Umut -günümüzde genelde sessiz olan bir umut- ne zaman nedensel sorular ortaya çıksa verinin kendisinin bizi doğru cevaplara yönlendirecek olması” (Pearl ve Mackenzie, 2018, s. 16). Pearl ve Mackenzie’nin bu görüşe karşı eleştirel olduğunu eklemem gerek.

Ufak Turing testi

Anderson bilimin nedenler olmadan da devam edebileceğini söyleyen ilk kişi değildi. 19. yüzyılın sonunda modern istatistiğin öncülerinden biri olan Karl Pearson, nedenlerin bilimde yeri olmadığını iddia etmiş (Pearl ve Mackenzie, 2018, s. 67) ve 20. yüzyılın başlangıcında yüzyılın en etkili felsefecilerinden biri olan Bertrand Russell, “nedensellik yasası”nı “geçmiş çağın kalıntısı” olarak isimlendirdiği Neden Kavramı Üzerine, (On the Notion of Cause) isimli kitabı yazmıştı (Russell, 1963, s. 132). Örneğin cisimler karşılıklı kütle çekiminin altında hareket ettiğinde, Russell’a göre hiçbir şey bir neden ve bir sonuç olarak adlandırılamaz (Russell, 1963, s. 141). Russell, Newton mekaniğinin Joseph-Louis Lagrange ve William Hamilton tarafından kuvvet kavramının olmadığı soyut bir teori olarak yeniden formüle edildiğini eklemiş olabilir.

Fakat Russell nedenselliği yanlış yerde arıyordu. Newton’un teorisini basit bir şekilde hafife aldı ve Newton’ın kendisinin, onun zamanında “deneysel felsefe” olarak adlandırılan yaklaşımı desteklediğini unuttu. Fizik kuşkusuz deneysel bir bilim ve fizikçilerin deneyler gerçekleştirmek için etrafta dolaşabilmeleri, araçlar kullanabilmeleri, ölçekler okuyabilmeleri ve diğer fizikçilerle iletişime geçebilmeleri gerekir. Fizikçi Roger Newton’ın işaret ettiği gibi, bir fizikçi “…tabiatın bir parçasını sallayarak ve diğer parçaların nasıl tepki verdiğini izleyerek etkili bir şekilde deneyler yürütür” (Newton, 1997, s. 142). A’nın, B’ye neden olup olmadığını bulmak için “A’nın bizim kontrolümüz altında olması” önemlidir (Newton, 1997, s. 144).

Halihazırda Pearl ve Mackenzie’nin Neden Sorusunun Kitabı (The Book of Why; 2018) isimli kitabından alıntı yaptım. Kitabın ana argümanı, bir bilgisayarda insan benzeri bir zekâ yaratmak için bilgisayarın nedensellik üzerine ustalaşabiliyor olması gerekmesiydi. Pearl ve Mackenzie şu soruyu soruyor:

“Makineler (ve insanlar), üç yaşındaki bir çocuğun yapabileceği gibi, nedensel bilgiyi nasıl gerekli bilgiye hızlıca ulaşmalarını, soruları doğru cevaplamalarını ve bunu kolaylıkla yapmayı mümkün kılacak şekilde temsil edebilirler?” (Pearl ve Mackenzie, 2018, s. 37).

Bunu “ufak bir Turing testi” olarak adlandırıyorlar. Ufak sıfatına sahip çünkü tam bir Turing testi değil, nedensel ilişkilere sınırlı.

Ufak Turing testine girmeden önce kısaca Turing testini hatırlatacağım. Bilgi İşlem Makineleri ve Zekâ[4] (Computing Machinery and Intelligence; Turing, 1950) isimli makalesinde, Alan Turing bir soru sordu: Bilgisayarların genel zekâya erişip erişmediğini nasıl belirleyebiliriz? Cevaplamaya çalıştığı sorunun “makineler düşünebilir mi?” olduğunu söyleyerek başlıyor ama zekâ nedir sorusuna girmek yerine bir oyun kurguluyor. Oyunda soru soran kimse bir bilgisayarla ve bir insanla iletişim kurabilir. Bir klavye aracılığıyla iletişim kurmak zorunda, böylece kim bilgisayar kim insan bilmeyecek. Olay şu ki makine bir insanmış gibi davranacak ve soru soran kişinin görevi ikisinden hangisinin bilgisayar ve hangisinin insan olduğuna karar vermek. Eğer soru soran kişi ayırt edemiyorsa, bilgisayarın zeki olduğunu söyleyebiliriz. Turing bunu “taklit oyunu” (the imitation game) olarak isimlendirdi ama daha sonra “Turing testi” olarak bilinir oldu. Turing’e göre, eğer bilgisayar testi geçerse genel zekâyı elde etmiştir.

Pearl ve Mackenzie’ye göre, Turing testini geçmenin asgari gerekliliği bilgisayarın nedensel sorularla baş edebiliyor olmasıdır. Evrimsel bir perspektiften bakınca bu mantıklı. Homo sapiens’in evrim tarihinde neden çok başarılı olduğu tabii ki karmaşık bir soru. Bu pek çok faktörle ilişkili ve işbirliği yapma becerisi muhtemelen en önemlilerinden biri. Ancak, belirleyici bir adım 70.000 ila 30.000 yıl öncesinde yer aldı, tarihçi Yuval Harari bunu Bilişsel Devrim (Cognitive Revolution) olarak adlandırıyor (Harari, 2014, s. 23). Harari’ye göre Bilişsel Devrimin ayırt edici işareti var olmayan bir şeyi hayal edebilme becerisi. Harari’nin örneği Almanya’daki Stadel Mağarasında bulunan ve yaklaşık 32.000 yaşında olan fildişi heykelcik “aslan adam” (ya da “aslan kadın”). Heykel bir insan vücudu ve aslan kafasından oluşuyor.

Pearl ve Mackenzie, Harari’ye atıf veriyor ve aslan adamın yaratılışının felsefenin, bilimsel keşfin ve teknolojik inovasyonun işareti olduğu ekliyorlar. Bu yaratı için temel önkoşul “eğer … yaparsam ne olur?” şeklindeki soruları sorma ve cevaplama becerisidir (Pearl ve Mackenzier, 2018, s. 2).

Ufak Turing testi nedensel ilişkilerle sınırlandırılmıştır. Eğer bilgisayarlar nedensel bilgiyi kullanabilirlerse testi geçeceklerdir. Ancak bu konudaki sorun şu ki bilgisayarlar onlarca yıldır herhangi bir ilerleme göstermedi: “Aynı 30 yıl önce yaptıkları gibi, makine öğrenimi programları (derin nöral ağlara sahip olanlar dahil) neredeyse tamamen ilişkisel bir modda çalışıyor …” (Pearl ve Mackenzie, 2018, s. 30). Ama bu yetersiz. Nedensel soruları cevaplamak için dünyaya müdahale edebiliyor olmalıyız.

Pearl ve Mackenzie’ye göre sorunun kaynağı bilgisayarların bir gerçeklik modeline sahip olmaması. Ancak, sorun şu ki kimse bir gerçeklik modeline sahip olamaz. Herhangi bir model sadece gerçekliğin basitleştirilmiş yönlerini resmedebilir. Gerçek sorun bilgisayarların dünyada olmaması çünkü bedenlenmiş (embodied) değiller.

Gerçek Turing testi

Pearl ve Mackenzie, bilgisayarların ufak Turing testini geçmeyi başaramayacağını çünkü nedensel soruları cevaplayamayacaklarını iddia etmekte haklıydı. Ben de bilgisayarların dünyada olmadıkları ve bu nedenle herhangi bir anlayışa sahip olmadıkları için tam Turing testini geçemeyeceklerini savunacağım. Turing testinden birkaç örnek bunu gösterecek.

Bir insana en çok benzeyen YZ programına ödül (Loebner Ödülü) verilen yıllık bir yarışma var. Yarışma bir Turing testi ama altın veya gümüş madalyalar şimdiye kadar hiç verilmedi. Mitsuku programı, 2013, 2016, 2017, 2018 ve 2019 yıllarında yarışmanın kazananıydı.

Felsefeci Luciano Floridi, yarışma 2008’de İngiltere’de ilk defa yapıldığında hakem heyetine nasıl katıldığını anlatır. Hakemlerden biri şu soruyla başlamıştı: “Eğer birbirimizin elini tutsaydık, o zaman ben kimin elini tutuyor olurdum?” Bilgisayar tamamen başka bir şey hakkında konuşarak cevap verdi: “Sonsuzlukta yaşıyoruz. Bu yüzden hayır, İnanmıyoruz.” Diğer bir soru şöyleydi: “Üç, Manchester ve Liverpool, İngiltere’nin dört başkent şehridir. Bu sorudaki hata nedir?” Bilgisayarın buna anlamlı bir cevabı yoktu (Floridi, 2014, s. 133).

Floridi’nin bahsettiği konuşma 10 yıldan daha öncesinde gerçekleşti. Programın gelişip gelişemediğini görmek konusunda meraklıydım. Birkaç kere denedim ama çok fazla gelişmemiş. Aşağıdaki bir örnek. 2008 yılında Mitsuku’ya “Eğer birbirimizin elini tutsaydık, o zaman ben kimin elini tutuyor olurdum?” sorusu sorulduğunda, bilgisayar başarısız olmuştu. Bu sefer doğru cevapla geldi. Ancak başarısız olması çok sürmedi. Aşağıdaki çıktıda “Millie” ya Mitsuku bilgisayar ya da bir insan olabilir. Konuşmanın sonunda, kişinin bir bilgisayarla mı yoksa bir insanla mı konuştuğunu tahmin etmesi gerekiyor. Konuştuğumun bir bilgisayar olduğunu belirlemek zor değildi.

İşte “konuşma”:

Mitsuku sohbet robotu Hoş geldin Ragnar, şimdi konuşuyor. * Konu ’Turing Testi’ * Yönetici tarafından ayarlandı (1 gün önce)

<Ragnar> Eğer elini sıkarsam, kimin elini tutuyor olurum?

<Millie> Ben senin elini tutuyor olurum ev sen benim elimi tutuyor olursun. Bu aptalca soruların olayı ne?

<Ragnar> Soru neden aptalca?

<Millie> Senin hakkında her şeyi bilmek istiyorum.

<Ragnar> Ama soruyu neden aptalca olarak değerlendirdiğini açıklamadın.

<Millie> Üzgünüm, unutmuş olmalıyım. Sorun neydi acaba?

<Ragnar> Eğer elini sıkarsam, kimin elini tutuyor olurum?

<Millie> Birbirimizin elini tutuyor oluruz.

<Ragnar> Ve bu neden aptalca bir soru?

<Millie> Neden varım? (MitsukuAnasayfa. Mitsuku’nun yazım yanlışını korudum)

Bilgisayarlar başarısız oluyor çünkü dünyada değiller. Mitsuku ilk soruyu aptalca olarak nitelendirdi ama nedenini açıklayamadı. Herhangi bir çocuk bunu yapardı.

Ancak, Loebner Ödülü yarışma kuralları değişti. Bilgisayarların Turing testini geçmesini sağlama amacından vazgeçildi çünkü “… tipik olarak sohbet robotlarının maskesi o kadar hızlı bir şekilde düşüyor ki ödül her zaman aralarından ‘en iyisine’ veriliyordu” (LoebnerPrize).

Sonuç: bilgisayarlar Dünya’da değiller

Bu yazının ana tezi şu: YGZ’yi gerçekleştiremeyeceğiz çünkü bilgisayarlar dünyada değil. Ancak “dünya” ile neyi kastettiğimizi açıklığa kavuşturmak çok önemli.

Bilim tarihçisi Alexandre Koyré’nin işaret ettiği gibi 17. yüzyıl bilimsel devriminin en önemli başarısı Aristocu bilimin soyut bir bilimsel idealle (“paradigma”) değiştirilmesidir (Koyré, 1978, ss. 38–39). Koyré, ikna edici bir biçimde Galileo’nun temelde bir Platoncu olduğunu savundu (Koyré, 1968). Platon örneğinde olduğu gibi, anahtar matematikti. Galileo’ya göre tabiatın kitabı matematiğin diliyle yazılmıştır (Galilei, 1970, s. 237). Bu yüzden Galileo’nun dünyası, Platon’un idealar dünyasına yakın, soyut ve idealize edilmiş bir dünyadır.

Bu ideal dünyaya en çok yaklaşan sistem, Isaac Newton’ın “dünyanın sistemi” olarak adlandırdığı, bizim güneş sistemimizdir. Newton’ın mekaniği, bilimin tamamı için bir model haline geldi. Bu idealin en iyi ifadesi, Fransız matematikçi Pierre Simon de Laplace tarafından verilmiştir. Prensipte bir gezegen ve bir molekül arasında hiçbir fark olmadığını savunur. Eğer zamanın bir noktasındaki evrenin durumunun tam bilgisine sahip olsaydık, daha önceki veya ardından gelen herhangi zamandaki durumu prensipte belirleyebilirdik (Laplace, 1951, s. 6). Bu demek oluyor ki evren bir bütün olarak bir algoritma ile tanımlanabilir. Turing, Bilgi İşlem Makineleri ve Zekâ makalesinde Laplace’a ait bu pasaja atıfta bulunuyor ve Turing’in dikkate aldığı öngörülerin, Laplace tarafından dikkate alınan ve evreni bir bütün olarak dahil eden öngörülere göre uygulanabilirliğe daha yakın olduğunu ekliyor (Turing, 1950, s. 440).

Russell’ın ifade ettiği gibi, bu dünyada nedenler hakkında konuşamayız bile, sadece matematiksel fonksiyonlar söz konusu. Ampirik bilimlerin çoğu nedensel olduğundan dolayı bu ideal dünyanın bir parçası. En çok yaklaşan bilimler klasik mekanik ve teorik fizik.

Bu ideal dünya, herhangi bir yerde gerçekleşmeyen metafiziksel bir fikir olmasına rağmen muazzam bir tarihi etkiye sahip oldu. Galileo ve Descartes sonrasında gelen çoğu felsefeci ve bilim insanı bunu gerçek dünya olarak ele aldılar ve bu gerçekleşen her şeyin “temelde” matematiksel yasalar, algoritmalar tarafından yönetildiğini ima ediyor. Bu organik dünya için de geçerli. Descartes için insan vücudu dahil bütün organizmalar makine. Bugün bunları robot veya bilgisayar olarak adlandırabiliriz. Descartes, maddi dünyanın bir parçası olmayan ve bu nedenle tabiat kuralları tarafından yönetilmeyen insan ruhunu bir istisna olarak görmüştür. Maddi olmayan ruh (immaterial soul) insanın özgür iradesini açıklar.

Günümüzde YGZ’nin savunucularının (ve güçlü YZ savunucularının) çoğu Descartes’ın maddi olmayan ruhunu dışlayacak ve Yuval Harari’nin argümanlarını takip edeceklerdir. Harari, 21. Yüzyıl İçin 21 Ders (21 Lessons for the 21st Century) isimli en son kitabında kararlarımızın “gizemli bir çeşit özgür irade”nin sonucu değil, “bir anda olasılıkları hesaplayan milyonlarca nöron”un sonucu olduğunu gösterdiğini iddia eden nörobilime ve davranışsal iktisada atıfta bulunuyor (Harari, 2018, s. 20). Bu bakışa göre YZ pek çok şeyi insanlardan daha iyi yapabilir. Harari yayalarla dolu bir caddede araba sürme, yabancılara borç para verme ve iş anlaşmalarında müzakere etme öneklerini veriyor. Bu işler “diğer insanların duygularını ve arzularını doğru bir şekilde değerlendirme” becerisini gerektiriyor. Gerekçesi şu ki:

“Yine de eğer gerçekten bu duygular ve arzular biyokimyasal algoritmalardan başka bir şey değilse, bilgisayarların bu algoritmaları deşifre edememesi için hiçbir sebep yok- ve bunu herhangi bir Homo sapiens’ten daha çok daha iyi yaparlar” (Harari, 2018, s. 21).

Bu alıntı Francis Crick tarafından kullanılan ifadeleri hatırlatıyor. Şaşırtan Varsayım (Astonishing Hypothesis) kitabında, kitabın başlığı şu şekilde açıklıyor:

“Şaşırtan Varsayım şu ki “Sen”, sevinçlerin ve kederlerin, anıların ve hırsların, kişisel kimlik hissin ve özgür iraden aslında bir araya gelmiş muazzam miktardaki sinir hücrelerinin ve onlarla bağlantılı moleküllerin davranışından fazlası değil” (Crick, 1994, s. 3).

Ancak iki alıntıda da sorunlar var. Eğer Harari ve Crick haklıysa o zaman bu alıntılar kimyasal algoritmaların sonucundan “başka bir şey değil” ve bir araya gelmiş muazzam miktardaki sinir hücrelerinin davranışından “fazlası değil”. O zaman nasıl doğru olabilirler ki?

Eğer öz referans sorununu görmezden gelirsek ve yukarıda (tek) gerçek dünya olarak tanımladığım bilimin ideal dünyasını kabul edersek, o zaman Harari’nin argümanı mantıklı oluyor. Fakat gündelik dünyamızı bilimin dünyasıyla değiştirmek temel bir yanlış anlaşılmaya dayanıyor. Edmund Husserl, ilk defa bu yanlış anlaşılmaya işaret edenlerden ve bunu Galileo’ya dayandıranlardan biriydi. Husserl için Galileo “… hem bir kâşif ve hem gizlenen bir deha” (Husserl, 1970, s. 52). Husserl bu yanlış anlaşılmayı “nesnelcilik” (objectivism) olarak adlandırdı. Bugün “bilimcilik” (scientism) daha yaygın kullanılan bir isim.

Bu görüşün aksine Husserl, bilimin temelde bir insan gayreti olduğunda ısrar etti. En soyut teoriler bile bizim gündelik dünyamızda, Husserl’in “yaşam-dünyası”nda, temelleniyor. Husserl, Einstein’ın izafiyet teorisinden bahsederek, bunun “Michelson’ın deneylerine[5] ve bu deneylerin diğer araştırmacılar tarafından desteklenmesine” bağlı olduğunu iddia ediyor (Husserl, 1970, s. 125). Bu tarz deneyler gerçekleştirmek için bilim insanlarının etrafta dolaşabilmeleri, araçlar kullanabilmeleri, ölçekler okuyabilmeleri ve diğer bilim insanlarıyla iletişime geçebilmeleri gerekir.

Diğer insanları nasıl anlayabildiğimizin Harari’ninkinden çok daha inandırıcı açıklamaları mevcut. Hubert Dreyfus’un ifade ettiği gibi bizler maddi ve sosyal bir dünyada yaşayan bedensel ve sosyal varlıklarız. Diğer bir kişiyi anlamak, kişinin beynindeki kimyaya bakmak değildir, hatta kişinin “ruh”una bakmak da değildir, daha ziyade kendini kişinin ”yerine” koymaktır. Bu kişinin yaşam-dünyasını anlamaktır.

Amerikalı yazar Theodore Roszak bu noktayı örneklemek için bir düşünce deneyi oluşturdu: Bir psikiyatristi işteyken izlediğimi hayal edelim. Çalışkan ve yetenekli bir psikiyatrist ve belli ki uygulamada çok iyi. Bekleme odası çeşitli duygusal ve zihinsel bozuklukları olan hastalarla dolu. Bazıları neredeyse histerik, bazılarının güçlü intihar düşünceleri, bazılarının halüsinasyonları var, bazıları en korkunç kabuslara sahip ve bazıları onlara zarar verecek insanlar tarafından izlendikleri düşüncesi tarafından deliliğe sürükleniyor. Psikiyatrist özenli bir şekilde her hastayı dinliyor ve onlara yardım etmek için elinden gelenin en iyisini yapıyor ama çok başarılı olamıyor. Aksine, psikiyatristin kahramanca çabalarına rağmen hepsi daha kötüye gidiyor gibi gözüküyor.

Şimdi Roszak bunu daha geniş bir bağlama koymamızı istiyor. Psikiyatristin ofisi bir binada ve bu bina bir yerde. Bu yer Buchenwald ve hastalar toplama kampındaki mahkûmlar (Roszak, 1992, s. 221). Biyokimyasal algoritmalar bize bu hastaları anlamamızda yardım etmeyecektir. Bize yardım edecek şey, aslında gerekli olan şey daha geniş bağlamı bilmektir. Eğer psikiyatristin ofisinin bir toplama kampında olduğunu bilmezsek, örnek kolaylıkla anlamsız bir hale gelir.

Sadece birkaçımız kendimizi bir toplama kampındaki mahkûmun yerine koyabiliriz. Bu yüzden, bizim deneyimlediklerimizden çok farklı durumlarda olan insanları tamamen anlayamayız. Fakat bir dereceye kadar anlayabiliriz ve anlayabiliriz çünkü biz de dünyadayız.

Bilgisayarlar bizim dünyamızda değiller. Daha önce nöral ağların programlanmaya ihtiyacı olmadığını ve bu yüzden zımni bilgiyi kullanabileceklerini söylemiştim. Ancak bazı Büyük Veri savunucularının iddia ettiği gibi verilerin “kendileri adına konuştuğu”, basitçe, doğru değil. Normalde kullanılan veriler bir veya daha çok modelle ilgilidir, insanlar tarafından seçilirler ve sonuçta sayılardan oluşurlar.

Eğer dünyanın “temelde” algoritmalar tarafından yönetildiğini düşünürsek, örneğin Harari gibi, o zaman YZ’nin gücünü abartma ve insan başarısını hafife alma eğiliminde oluruz. Harari’den olan alıntılarda görünen “başka bir şey değil” ifadesi, insani ve sosyal olguların tanımında ciddi bir aşırı basitleştirmeye yol açabilir. Bunun hem IBM Watson Health hem de Alphabet’in DeepMind başarısızlıklarının açıklamasının en azından bir parçası olduğunu düşünüyorum. “IBM, makinelerin öğrenme şekli ve doktorların çalışma şekli arasında temel bir uyuşmazlık ile karşılaştı” (Strickland, 2019) ve DeepMind “Go için çalışan şeyin DeepMind’ın YZ ile çözmeyi çok istediği kanser ve temiz enerji gibi zorlayıcı sorunlar için çalışmayabileceğini” (Marcus, 2019) keşfetti.

YZ’nin gücünün abartılmasının bilim üzerinde de yıkıcı etkileri olabilir. Sıklıkla alıntılanan İkinci Makine Çağı (Second Machine Age) kitabında, Erik Brynjolfson ve Andrew McAfee dijitalleşmenin geçmişi anlamamızda bize yardımcı olabileceğini öne sürüyorlar. 1800’den beri İngilizce yayınlanmış beş milyondan fazla kitabı analiz etmiş bir projeye atıfta bulunuyorlar. “İngilizcedeki kelime sayısının, 1950 ve 2000 yılları arasında %70’ten daha fazla artmış olması, şöhretin insanlara daha hızlı geldiği ama daha hızlı da azaldığı ve 20. yüzyılda evrime ilginin Watson ve Crick DNA’nın yapısını keşfedene kadar azalıyor olduğu” projenin sonuçlarından bazıları. Bu sözüm ona “dijitalleşme ile daha iyi anlayışa ve öngörüye-diğer bir deyişle, daha iyi bilime” götürüyor (Brynjolfson ve McAfee, 2014, s. 69). Benim görüşüm bunun daha ziyade Karl Popper’ın içgörüsünün bir örneklemesi olduğu: “Çok fazla dolar çok az sayıda fikri kovalayabilir” (Popper, 1981, s. 96).

Benim sonucum oldukça basit: Hubert Dreyfus’un genel YZ’ye karşı argümanları hala geçerli.

Notlar

[1] Gerçekliğe veya varoluşa ilişkin yanlış ve bozuk inançlar, episteme kavramının zıttı. (E. N.)

[2] Polanyi normalde, “bilme”yi kişisel boyutu vurgulamak için “bilgi” yerine kullanır. Ancak ben daha geleneksel olan “bilgi”yi kullanacağım.

[3] Örnek Jeopardy! üzerine olan Wikipedia makalesinden alındı.

[4] Metnin CogIST tarafından yapılmış Türkçe çevirisine buradan ulaşabilirsiniz. (E. N.)

[5] Fjelland (1991) içerisinde bulunan Michelson araçlarının detaylı bir tanımını verdim.

Kaynakça

Anderson C (2008) The end of theory: the data deluge makes the scientific method obsolete. Wired Magazine

Bolter D (1986) Turing’s man. Western culture in the computer age. Penguin Books

Brynjolfson E, McAfee A (2014) The second machine age. Norton & Company

Chen X-W, Lin X (2014) Big Data deep learning: challenges and perspectives. IEEE Access 2:514–525

Crick F (1994). The astonishing hypothesis. The scientific search for the soul. Macmillan Publishing Company

Dingli A (2018) “Its Magic….I Owe You No Explanation!” 2018. https://becominghuman.ai/its-magic-i-owe-you-no-explanation-explainableai-43e798273a08. Accessed 5 May 2020

Dreyfus HL (1972) What computers can’t do. Harper & Row, New York, NY

Dreyfus HL, Dreyfus SE (1986). Mind over machine. Basil Blackwell

Fjelland R (1991) The Theory-Ladenness of observations, the role of scientific instruments, and the Kantian a priori. Int Stud Philos Sci 5(3):269–80

Floridi L (2014) The 4th revolution. How the infosphere is reshaping human reality. Oxford University Press, Oxford

Ford M (2015) The rise of the robots. technology and the threat of mass unemployment. Oneworld Publications, London

Galilei G (1970) Dialogue concerning the two chief world systems (1630). University of California Press, Berkeley, Los Angeles

Harari YN (2014). Sapiens. A brief history of humankind. Vintage

Harari YN (2018) 21 Lessons for the 21st century. Jonathan Cape, London

Husserl E (1970) The crisis of european sciences and transcendental phenomenology. Northwestern University Press, Evanston

Jones N (2014) The learning machines. Nature 505:146–48

Koyré A (1968) Galileo and Plato. In: Metaphysics and measurement (1943). John Hopkins Press, Baltimore, London.

Koyré A (1978) Galileo studies (1939). Harvester, London

Lanier J (2013) Who owns the future? Allen Lane, London

Laplace PS (1951) Philosophical essay on probabilities (1814). Dover Publications, New York

Lazer D, Kennnedy R, King G, Vespignani A (2014) The parable of google flu: traps in big data analysis. Science 343:1203–1205

LoebnerPrize. https://artistdetective.wordpress.com/2019/09/21/loebner-prize-2019. Accessed 5 May 2020

Marcus G (2019) DeepMind’s losses and the future of artificial intelligence. Wired 14.8.2019. https://www.wired.com/story/deepminds-losses-future-artificialintelligence/. Accessed 6 Jan 2020

Mayer-Schönberger V, Cukier K (2014) Big data: a revolution that will transform how we live, work, and think. Eamon Dolan/Mariner Books

Mill JS (1882) A system of logic, ratiocinative and inductive, being a connected view of the principles of evidence, and the methods of scientific investigation, 8th edn. Harper & Brothers, New York

Minsky M (1972) Computation: finite and infinite machines. Prentice-Hall International

MitsukuHomepage. http://www.square-bear.co.uk/mitsuku/home.htm. Accessed 12 Sept 2017

Najafabadi MM, Villanustre F, Khoshgoftaar TM, Seliya N, Wald R, Muharemagic E (2015) Deep learning applications and challenges in big data analytics. J Big Data 2(1). https://doi.org/10.1186/s40537-014-0007-7

Newton RG (1997) The truth of science. Physical theories and reality. Harvard University Press, Cambridge

Nielsen M (2016). Is alphago really such a big deal? Quanta Magazine, March 29, 2016. https://www.quantamagazine.org/is-alphago-really-such-a-big-deal-20160329/. Accessed 7 Jan 2020

Pearl J, Mackenzie D (2018) The book of why. The new science of cause and effect. Basic Books, New York

Penrose R (1989) The emperor’s new mind. Concerning computers, minds, and the laws of physics. Oxford University Press, Oxford

Penrose R (1994) Shadows of the mind. A search for the missing science of consciousness. Oxford University Press, Oxford

Plato (1955) The republic. Penguin Books, Harmondsworth, p. 1955

Polanyi M (1958) Personal knowledge. Routledge & Kegan Paul, London

Polanyi M (2009) The tacit dimension (1966). The University of Chicago Press, Chicago

Popper KR (1981) The rationality of scientific revolutions (1975). In: Hacking Ian ed Scientific revolutions. Oxford University Press, Oxford, pp. 80–106

Roszak T (1992) The voice of the earth. Simon & Shuster, New York

Russell B (1963). On the notion of a cause (1912). In: Mysticism and logic. Unwin Books, London

Sagan L (1996) Electric and magnetic fields: invisible risks? Gordon and Breach Publishers, Amsterdam

Searle J (1980) Minds, brains, and programs. Behav Brain Sci 3(3):417–57

Shane J (2019) You look like a thing and I love you. Wildfire, London

Strickland E (2019) How Ibm Watson overpromised and underdelivered on Ai Health Care. IEEE Spectrum, 2 April 2019. https://sprectrum.ieee.org/biomedical/diagnostics/how-ibm-watson-overpromised-and-underdeliveredon-ai-health-care. Accessed 5 Jan 2020

Susskind R, Susskind D (2015) The future of the professions. Oxford University Press, Oxford

Tegmark M (2017) Life 3.0. Being human in the age of artificial intelligence. Alfred A. Knopf, New York

Turing A (1950) Computing machinery and intelligence. Mind LIX 236:433–60

Weizenbaum J (1976) Computer power and human reason. Freeman & Company, San Francisco

Wikipedia: Jeopardy!, https://en.wikipedia.org/wiki/Jeopardy! Accessed 2 Feb 2017

Bu makale CC BY 4.0 lisansı altında Türkçe’ye çevrilmiştir. © 2020 Ragnar Fjelland

Alıntı: Fjelland, R. Why general artificial intelligence will not be realized. Humanit Soc Sci Commun 7, 10 (2020). https://doi.org/10.1057/s41599-020-0494-4